GoogleのAIチップ TPU?

GoogleのAIチップの歴史を、**「データセンターの巨大脳(TPU)」と「スマホの手のひら脳(Tensor)」**の2つのラインに分けて、初代から最新の第7世代まで時系列でまとめました。

GoogleがどのようにAIを進化させてきたか、その足跡がはっきりと分かります。

【歴史1】データセンター向け:Cloud TPU の系譜

Google内部の「計算需要」の爆発に合わせて進化してきました。

| 世代 | 年 | 名称・役割 | 歴史的意義・エピソード |

| 初代 | 2015 | TPU v1 (推論のみ) | 【伝説の始まり】 囲碁AI「AlphaGo」がトップ棋士イ・セドルに勝利した際に使用。「学習」はできず、完成したAIを動かす「推論」専用でした。GPUより桁違いに省電力でした。 |

| 第2世代 | 2017 | TPU v2 (学習対応) | 【クラウド開放】 「学習(Training)」が可能になり、Google Cloud経由で一般企業にも貸し出し開始。ここからGoogleのAI大衆化が始まりました。 |

| 第3世代 | 2018 | TPU v3 (液冷導入) | 【熱との戦い】 性能を上げるため発熱が凄まじくなり、チップ冷却に**「液冷(水冷)」**を導入。v2の8倍の性能を実現。 |

| 第4世代 | 2021 | TPU v4 (光スイッチ) | 【ネットワーク革命】 チップ同士をつなぐ配線に**「光回路スイッチ (OCS)」**を導入。物理ケーブルを繋ぎ変えずとも、数千個のチップ構成を瞬時に変更可能に。 |

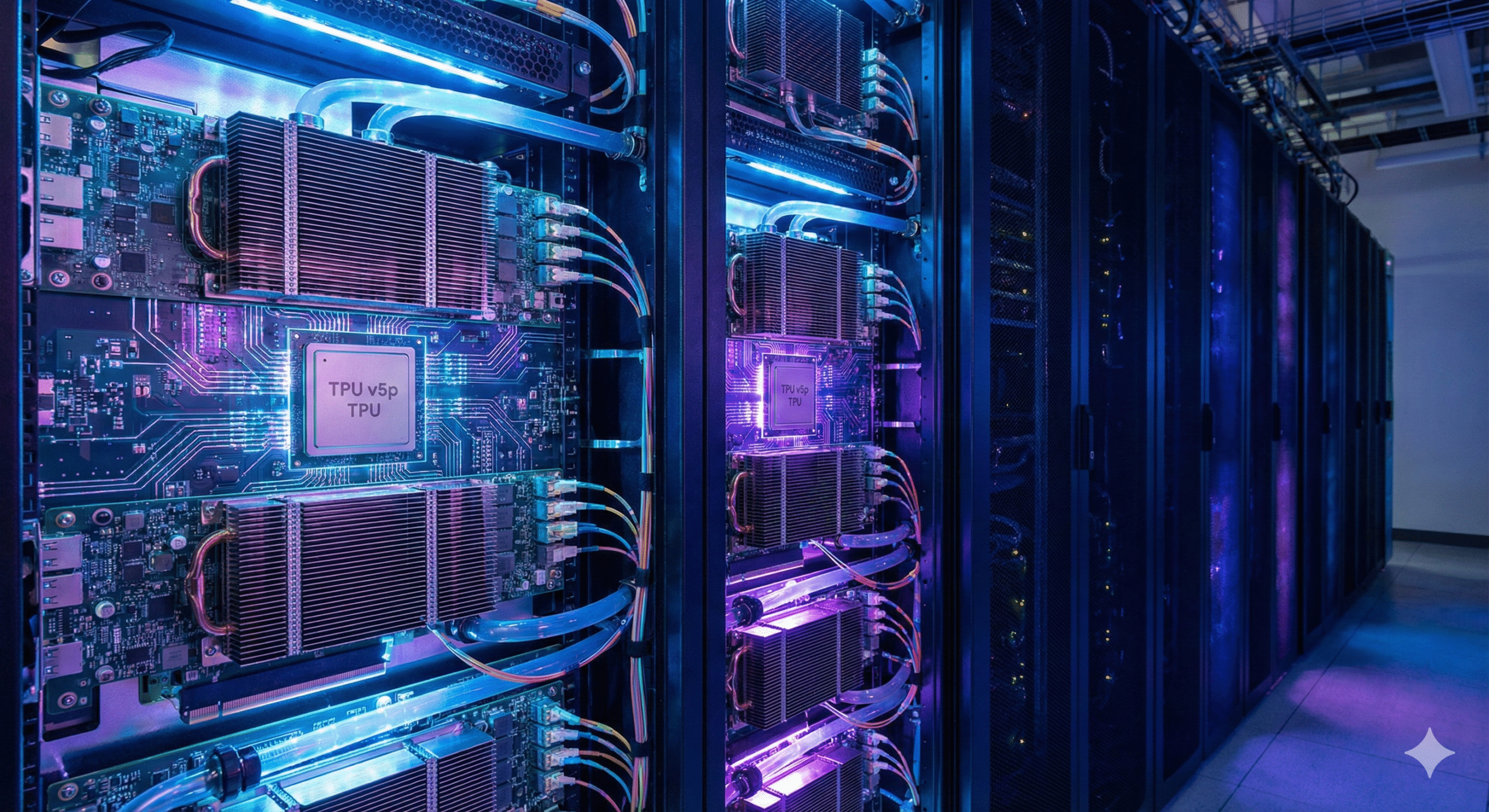

| 第5世代 | 2023 | TPU v5e / v5p (LLM特化) | 【生成AI時代】 コスト重視の「e (Lite)」と性能重視の「p」に分岐。Geminiのような巨大言語モデル(LLM)を効率よく学習させるために最適化されました。 |

| 第6世代 | 2024 | Trillium (超・省電力) | 【究極の効率】 エネルギー効率を極限まで追求。v5e比で4.7倍の性能。世界的な電力不足懸念に対応するための一手。 |

| 第7世代 | 2025 | TPU v7 “Ironwood” (推論特化) | 【実用フェーズへ】 学習よりも「推論」に特化。世界中のユーザーが毎日Geminiを使うための、超大帯域メモリ(HBM)を搭載した運用特化型。 |

【歴史2】スマホ向け:Google Tensor の系譜

Pixelスマートフォンに搭載されているチップです。「ベンチマークの数値」より「AI体験」を重視する歴史です。

| 世代 | 年 | 搭載機種 | 歴史的意義・エピソード |

| 前史 | 〜2020 | Pixel 5まで | Qualcomm Snapdragon時代 他社と同じ汎用チップを使っており、Google独自のAI機能(カメラ処理など)を載せるのに限界を感じていました。 |

| 初代 | 2021 | Tensor G1 (Pixel 6) | 【自社チップの夜明け】 Samsungと共同開発。Google独自のTPUを内蔵し、「消しゴムマジック」や「リアルタイム翻訳」をオンデバイスで実現。 |

| 第2世代 | 2022 | Tensor G2 (Pixel 7) | 【洗練】 初代の発熱やバグを改善し、AI処理能力を60%向上。「ボケ補正機能」などが追加されました。 |

| 第3世代 | 2023 | Tensor G3 (Pixel 8) | 【生成AI対応】 オンデバイスでの生成AI動作を視野に設計。「音声消しゴムマジック」や「ベストテイク」など、AI編集機能が大幅強化。 |

| 第4世代 | 2024 | Tensor G4 (Pixel 9) | 【マルチモーダル】 Gemini Nano(スマホ版Gemini)を快適に動かすために設計。ウェブ読み上げやスクリーンショットのAI解析に対応。 |

| 第5世代 | 2025 | Tensor G5 “Laguna” (Pixel 10予定) | 【完全自社設計へ】 Samsungへの委託をやめ、設計をGoogleが完全掌握し、製造をTSMCに変更。劇的な性能向上と省電力化が期待される転換点。 |

| 第6世代 | 2026 | Tensor G6 “Malibu” (Pixel 11予定) | 【未来の技術】 TSMC 2nmプロセス採用の可能性。バッテリーを気にせず常時AIエージェントが動き続ける世界を目指す。 |

歴史から見える「Googleの意志」

この歴史を俯瞰すると、Googleの狙いがはっきりと見えてきます。

- 初期(v1〜v3):とにかく**「計算パワー」**を求めていた時代。AlphaGoや翻訳エンジンの精度を上げるために必死でした。

- 中期(v4〜v5):**「ネットワークと規模」**の時代。モデルが巨大化(LLM)したため、数千個のチップをいかにスムーズに繋ぐかに注力しました。

- 現在・未来(v6〜v7 / G5〜G6):「効率と実用」の時代。AIが当たり前のインフラになったため、「いかに少ない電力で」「いかに安く」「世界中のリクエストを捌くか」という運用フェーズに入っています。

Googleは、AIソフト(Gemini)を進化させるために、ハードウェア(TPU/Tensor)の歴史を自ら作ってきたと言えます。